Meta, açık üretken yapay zeka modellerinden oluşan Llama serisinin son üyesini piyasaya sürdü: Llama 3. Llama 3, daha önceki sürümlerde olduğu gibi elbette tek bir modelden oluşmuyor. Bu bağlamda Llama 3 şu anda 8B ve 70B parametreli iki model ağırlığına sahip. Bilmeyenler için milyar parametre ne kadar büyükse model de o kadar karmaşık ve güçlü oluyor. Bununla birlikte Meta, yeni nesil büyük dil modeli Llama’nın mevcut yapay zeka modellerinin çoğundan daha iyi performans gösterdiğini belirtiyor.

Meta yeni Llama 3 modellerinin (8B ve 70B) önceki nesil Llama modelleri olan Llama 2 8B ve Llama 2 70B’ye kıyasla performans açısından büyük bir sıçrama kaydettiğini aktarıyor. Meta, iki özel yapım 24.000 GPU kümesinde eğitilen Llama 3 8B ve Llama 3 70B’nin kendi parametre sayıları için bugün piyasadaki en iyi performans gösteren üretken yapay zeka modelleri arasında olduğunu söylüyor.

Gemini ve diğerlerinden daha güçlü

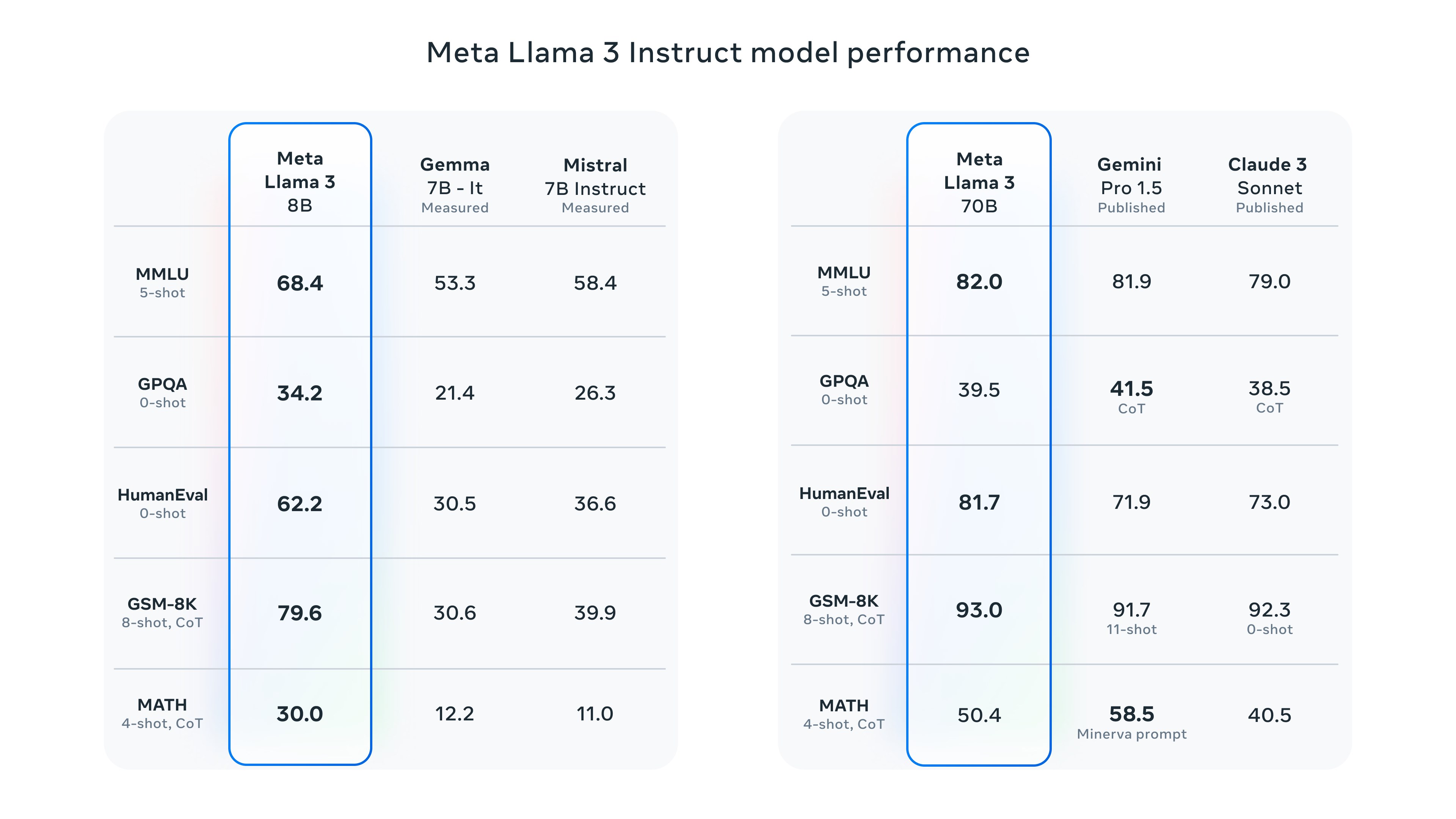

Şimdilik yalnızca metin tabanlı yanıtlar sunan Llama 3, yanıt verirken daha fazla çeşitlilik sunarken soruları da daha az reddediyor. Aynı zamanda Llama 3’ün daha fazla talimatı anladığı ve öncekinden daha iyi kod yazdığının altı çiziliyor. Meta, yayınladığı blog yazısında Llama 3’ün her iki boyutunun da belirli kıyaslama testlerinde Google’ın Gemma ve Gemini, Mistral 7B ve Anthropic’in Claude 3’ü geride bıraktığını söylüyor.

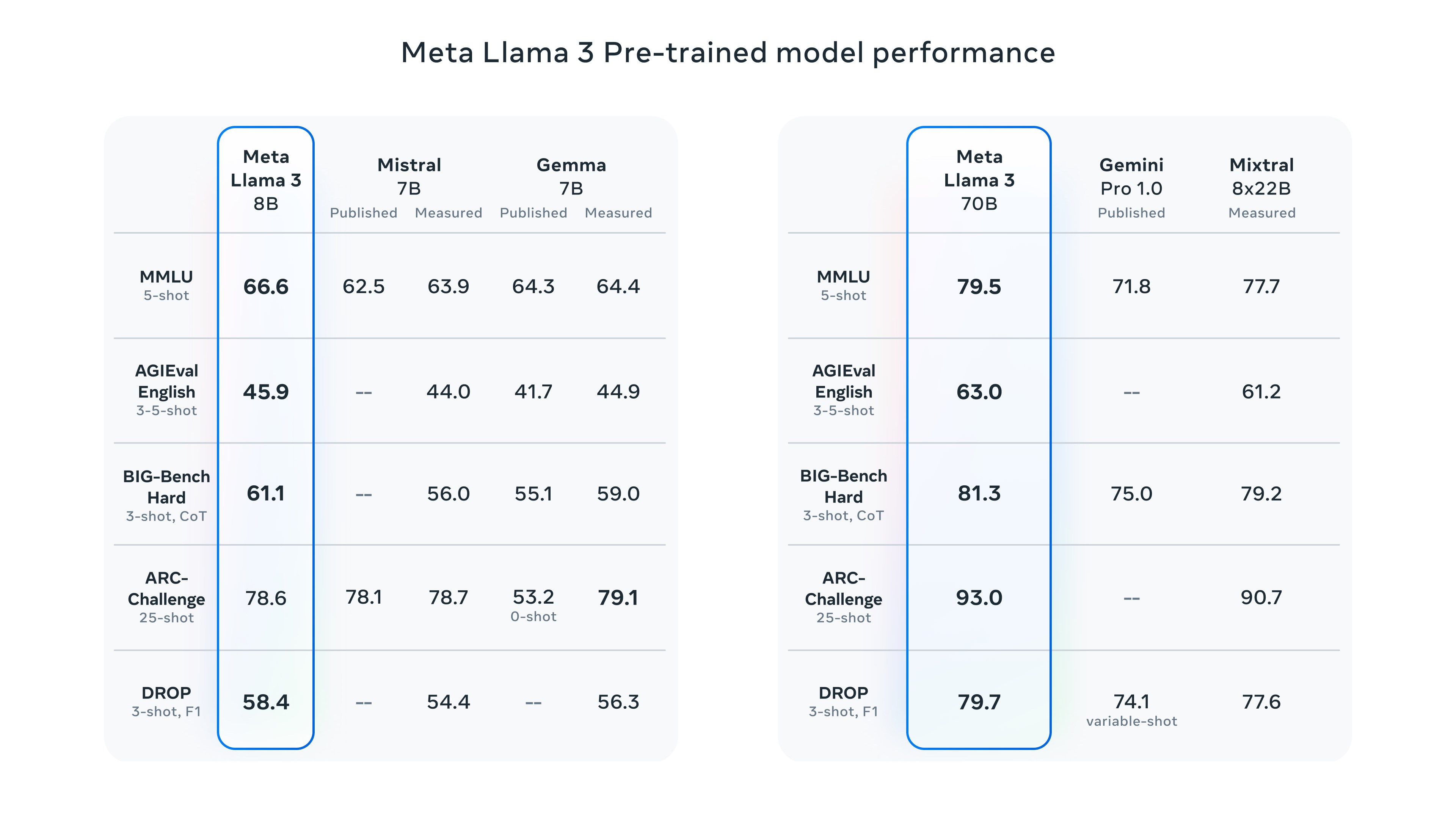

Peki Meta, bunu hangi temellere dayandırıyor? Şirket, Llama 3 modellerinin MMLU (bilgiyi ölçmeye çalışır), ARC (beceri edinimini ölçmeye çalışır) ve DROP (bir modelin metin parçaları üzerindeki muhakemesini test eder) gibi popüler yapay zeka karşılaştırmalarındaki puanlarına işaret ediyor. Ancak bunlar CPU’lar özelinde kullanılan sentetik kıyasla testleri gibidir, en doğru yanıtı vermezler. Ancak iyi ya da kötü genel bir değerlendirme sunmak için bunlar kullanılıyorlar.

Peki Meta, bunu hangi temellere dayandırıyor? Şirket, Llama 3 modellerinin MMLU (bilgiyi ölçmeye çalışır), ARC (beceri edinimini ölçmeye çalışır) ve DROP (bir modelin metin parçaları üzerindeki muhakemesini test eder) gibi popüler yapay zeka karşılaştırmalarındaki puanlarına işaret ediyor. Ancak bunlar CPU’lar özelinde kullanılan sentetik kıyasla testleri gibidir, en doğru yanıtı vermezler. Ancak iyi ya da kötü genel bir değerlendirme sunmak için bunlar kullanılıyorlar.  Llama 3 8B, her ikisi de 7 milyar parametre içeren Mistral’in Mistral 7B ve Google’ın Gemma 7B gibi diğer açık modelleri en az dokuz kıyaslamada geride bırakmayı başarıyor. Bununla birlikte Llama 3 70B’nin Google’ın Gemini 1.5 Pro da dahil olmak üzere Anthropic’in Claude 3 modelleriyle yakından rekabet ediyor ve bazen geçiyor. Yukarıdaki ve yazıdaki görsellerde alınan puanlara bakabilirsiniz.

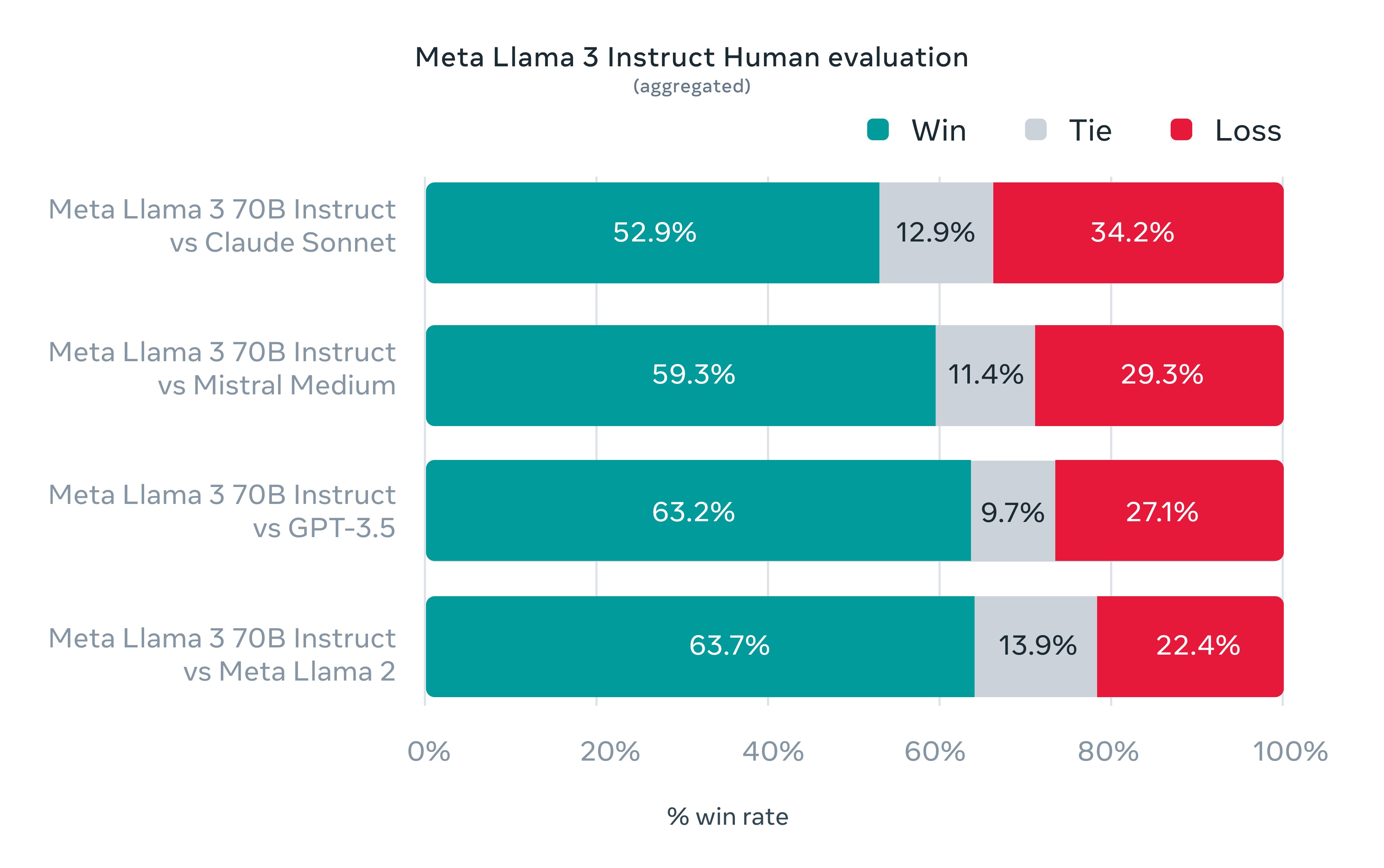

Llama 3 8B, her ikisi de 7 milyar parametre içeren Mistral’in Mistral 7B ve Google’ın Gemma 7B gibi diğer açık modelleri en az dokuz kıyaslamada geride bırakmayı başarıyor. Bununla birlikte Llama 3 70B’nin Google’ın Gemini 1.5 Pro da dahil olmak üzere Anthropic’in Claude 3 modelleriyle yakından rekabet ediyor ve bazen geçiyor. Yukarıdaki ve yazıdaki görsellerde alınan puanlara bakabilirsiniz. Bu arada, Meta’nın yayınladığı uzunca blog yazısında OpenAI’ın amiral gemisi modeli GPT-4’ten hiç bahsedilmemesi de ilginç. Öte yandan Meta, insanların Llama 3’ü GPT-3.5 de dahil olmak üzere diğer modellerden daha yukarıya yerleştirdiğini söylüyor. İnsanların yaptığı değerlendirmeler ise 12 temel kullanım durumunu kapsıyor: tavsiye isteme, beyin fırtınası, sınıflandırma, kapalı soru yanıtlama, kodlama, yaratıcı yazma, çıkarım yapma, bir karakteri/kişiliği canlandırma, açık soru yanıtlama, akıl yürütme, yeniden yazma ve özetleme.

Meta, yeni Llama modellerinin tarihle, mühendislik ve bilim gibi STEM alanlarıyla ilgili sorularda ve genel kodlama önerilerinde daha yüksek doğruluk sunduğunu söylüyor. Aslında bu, doğrudan daha büyük bir veri seti sayesinde mümkün oluyor: 15 trilyon token’den oluşan bir derleme veya Llama 2 eğitim setinin yedi katı büyüklüğünde akıllara durgunluk veren ~750.000.000.000 kelime. Bilmeyenler için token (buna belirteç veya jeton da deniyor), “fantastik” kelimesindeki “fan”, “tas” ve “tik” heceleri gibi alt bölümlere ayrılmış ham veri parçalarını ifade ediyor.

Meta, yeni Llama modellerinin tarihle, mühendislik ve bilim gibi STEM alanlarıyla ilgili sorularda ve genel kodlama önerilerinde daha yüksek doğruluk sunduğunu söylüyor. Aslında bu, doğrudan daha büyük bir veri seti sayesinde mümkün oluyor: 15 trilyon token’den oluşan bir derleme veya Llama 2 eğitim setinin yedi katı büyüklüğünde akıllara durgunluk veren ~750.000.000.000 kelime. Bilmeyenler için token (buna belirteç veya jeton da deniyor), “fantastik” kelimesindeki “fan”, “tas” ve “tik” heceleri gibi alt bölümlere ayrılmış ham veri parçalarını ifade ediyor. Daha büyük Llama 3 modelleri de yolda

Meta, tüm bu veriler için kamuya açık kaynaklardan yararlandığını, Llama 2 eğitim veri setinden dört kat daha fazla kod içerdiğini ve İngilizce dışındaki dillerde performansı artırmak için bu setin yüzde 5’inin İngilizce olmayan verilere (~30 dilde) sahip olduğunu açıkladı.

Meta, tüm bu veriler için kamuya açık kaynaklardan yararlandığını, Llama 2 eğitim veri setinden dört kat daha fazla kod içerdiğini ve İngilizce dışındaki dillerde performansı artırmak için bu setin yüzde 5’inin İngilizce olmayan verilere (~30 dilde) sahip olduğunu açıkladı. Meta, şu anda indirilebilen ve Meta’nın Facebook, Instagram, WhatsApp, Messenger ve web üzerindeki Meta AI asistanına güç veren Llama 3 modellerinin yakında AWS, Databricks, Google Cloud, Hugging Face, Kaggle, IBM’s WatsonX, Microsoft Azure, Nvidia NIM ve Snowflake gibi çok çeşitli bulut platformlarında barındırılacağını söylüyor. Gelecekte, modellerin AMD, AWS, Dell, Intel, Nvidia ve Qualcomm donanımları için optimize edilmiş versiyonları da kullanıma sunulacak.

Meta, Llama 3’ün çok modlu yanıtlar verebilmesini de sağlayacak daha kapsamlı modellerin halihazırda eğitim sürecinde olduğunu söylüyor. Meta, spesifik olarak 400B’den fazla parametreye sahip olan versiyona işaret ediyor. Llama 3 400B için firma şimdilik herhangi bir kıyaslama paylaşmadı ancak bunun çok fazla süreceğini düşünmüyoruz.